Quale è importanza dell’AI nella società moderna?

L’Intelligenza Artificiale (IA), disciplina che si occupa di creare macchine e sistemi in grado di eseguire compiti che richiedono intelligenza umana attraverso l’apprendimento di dati, riconoscimento di modelli, risoluzione di problemi, è fondamentale nella società moderna perché può migliorare l’efficienza, l’accuratezza e l’efficacia in una vasta gamma di settori, come la salute, la finanza, il marketing e la giustizia.

Il tutto grazie ad algoritmi che guidano il comportamento delle macchine intelligenti, addestrati per analizzare grandi quantità di dati, riconoscere modelli e prendere decisioni. Con il machine learning, gli algoritmi possono migliorare le proprie prestazioni con l’esperienza e diventare sempre più efficienti nel compiere compiti specifici.

Quali sono le premesse e le prospettive dell’Intelligenza Artificiale considerando le criticità del sistema degli algoritmi e i relativi rimedi tecnici e giuridici?

Le fantasie di possibilità tratte dal lavoro visionario di H.G. Wells sembrano materializzarsi nell’era moderna, con lo sviluppo rapido delle tecnologie e delle scienze. L’Intelligenza Artificiale rappresenta un passo significativo in questo progresso, con la capacità di elaborare grandi quantità di dati e produrre risultati simili a quelli umani. Tuttavia, ci sono sfide importanti legate agli algoritmi utilizzati nell’IA, in particolare i bias cognitivi e la discriminazione. Gli algoritmi imparano dai dati a loro disposizione, ma se questi dati riflettono pregiudizi o discriminazioni storiche, l’IA potrebbe perpetuarli. I rimedi a questa problematica possono essere di natura tecnica, come ad esempio addestrare gli algoritmi su set di dati più diversificati e rappresentativi, e di natura giuridica, attraverso normative che promuovono la non discriminazione e la parità di trattamento.

Recentemente, l’Unione Europea ha approvato il Regolamento sull’IA mirato a minimizzare il rischio di discriminazione algoritmica. In definitiva, l’obiettivo è sviluppare un’IA equa e responsabile che sia al servizio di tutti, promuovendo valori come trasparenza, equità e inclusione, e garantendo contesti in cui prevale la parità, la giustizia e i diritti fondamentali delle persone.

Ci sono, quindi, opacità e non trasparenza del mondo digital?

Si, direi di sì.

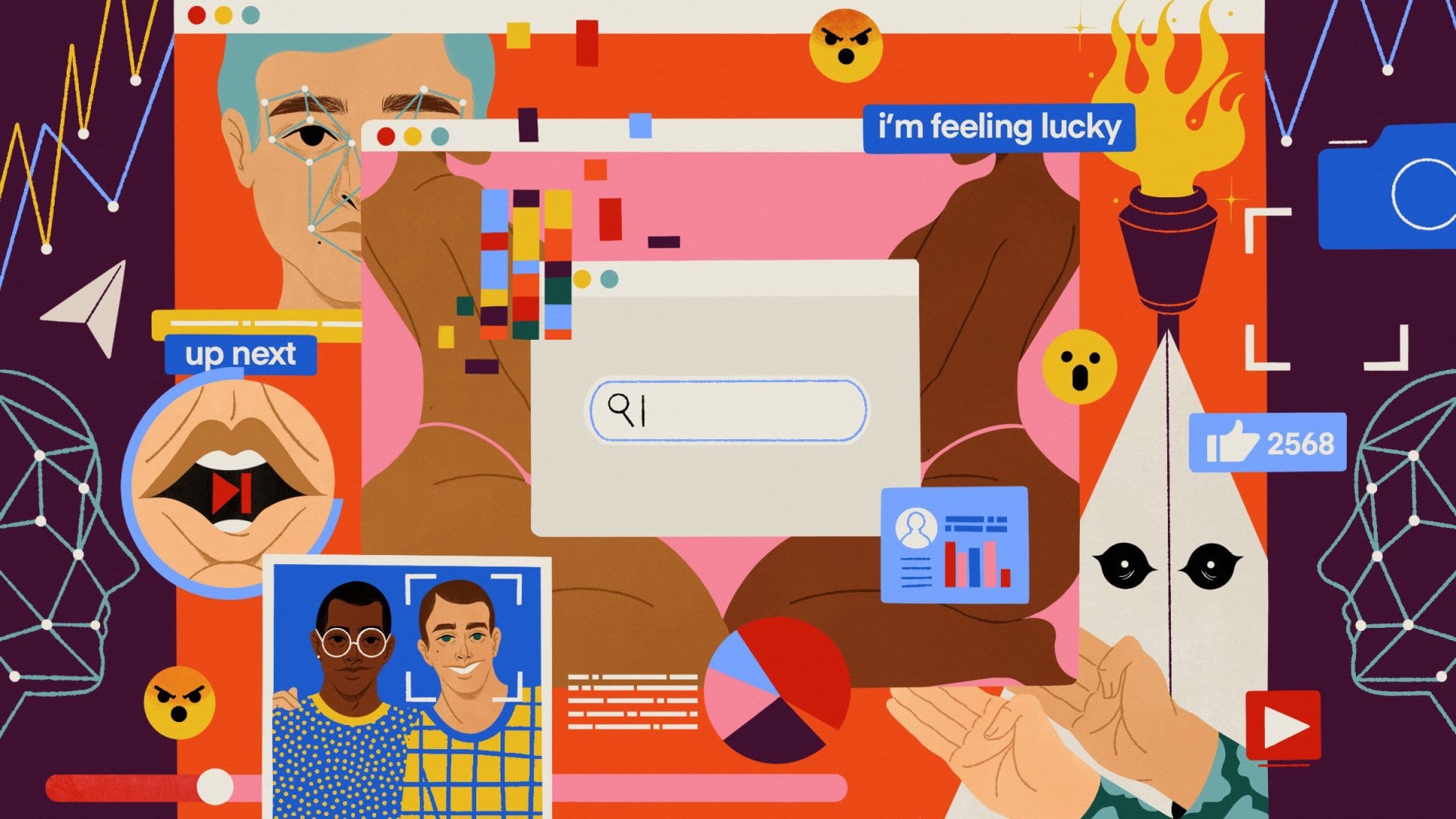

Il concetto di “Filter bubble” si riferisce all’isolamento intellettuale che si verifica a causa dei sistemi algoritmici che filtrano le informazioni in base alle preferenze e alle azioni degli utenti online. Questo concetto è stato teorizzato per la prima volta nel 2010 da Eli Pariser, un attivista della Rete. Le grandi piattaforme digitali utilizzano algoritmi per personalizzare le informazioni fornite agli utenti, creando così un’esperienza web unica per ognuno, che riflette gusti, opinioni e interessi individuali. Questo fenomeno è stato descritto come la creazione di diverse versioni del web, ognuna corrispondente alle preferenze degli utenti.

Il concetto di filter bubble non è nuovo e può essere associato alle “camere dell’eco”, che si riferivano originariamente ai media tradizionali come televisione e giornali. Tuttavia, mentre in passato le preferenze politiche e ideologiche determinavano le comunità di utenti intorno ai media tradizionali, oggi le filter bubble sono generate in modo meno evidente tramite algoritmi digitali.

Le filter bubble sono il risultato di varie attività online, come il tracciamento dei cookie e dei dati di navigazione sui siti web e l’uso di algoritmi sui social media per personalizzare i contenuti. Pariser ha delineato tre fasi attraverso le quali si forma una filter bubble: identificare gli interessi degli utenti, offrire contenuti adatti e plasmare l’identità mediatica dell’utente.

Esperimenti hanno dimostrato l’esistenza di filter bubble, come nel caso di ricerche su Google che restituivano risultati diversi in base alle preferenze degli utenti. Tuttavia, è stata evidenziata anche la tendenza degli utenti a interagire online con individui che condividono le stesse opinioni, contribuendo così all’isolamento ideologico.

Gli effetti indesiderati delle filter bubble includono la limitazione delle prospettive e la riduzione della qualità dell’informazione disponibile, il che può portare alla polarizzazione e all’estremizzazione delle opinioni politiche.

Quali sono i rimedi tecnici e giuridici per affrontare i rischi associati ai bias nell’Intelligenza Artificiale e il filter bubble?

Esistono a mio parere diversi approcci per affrontare questi rischi. Dal punto di vista tecnico, si possono adottare pratiche come l’utilizzo di set di dati rappresentativi e diversificati, il monitoraggio costante degli output dell’algoritmo e l’impiego di procedure di revisione multi-disciplinari durante lo sviluppo degli algoritmi. L’addestramento degli algoritmi per comprendere e rispondere al linguaggio umano presenta, pertanto, diverse sfide. Queste includono la comprensione del contesto e del significato implicito nelle frasi, la gestione dell’ambiguità e della polisemia, e la capacità di generare risposte coerenti e pertinenti. Inoltre, è importante evitare che gli algoritmi replichino pregiudizi o stereotipi presenti nel linguaggio umano.

Dal punto di vista giuridico, esistono normative che vietano la discriminazione e promuovono la parità di trattamento, sia a livello nazionale che internazionale.

Ad esempio, la Carta dei diritti fondamentali dell’Unione Europea e il GDPR stabiliscono norme per proteggere i cittadini dall’uso discriminatorio dell’IA.

Quindi l’obiettivo finale è implementare l’Intelligenza Artificiale in modo equo e responsabile?

Sicuramente sì.

L’obiettivo finale è garantire che l’IA sia utilizzata per promuovere valori come trasparenza, equità e diversità. Ciò significa sviluppare e utilizzare sistemi di IA che riflettano la diversità della società e evitino discriminazioni o pregiudizi. Questo richiede un equilibrio tra la tecnologia e il diritto, con normative e pratiche che promuovano l’utilizzo responsabile dell’IA per il benessere di tutti.

E soprattutto proteggere la privacy di ogni individuo.

A tal riguardo, come possono essere mitigati i rischi legati alla privacy nell’implementazione dell’Intelligenza Artificiale?

La protezione della privacy è fondamentale nell’utilizzo dell’IA. Per mitigare i rischi, è necessario adottare approcci come l’anonimizzazione dei dati sensibili, la limitazione dell’accesso ai dati solo al personale autorizzato, l’implementazione di robuste politiche di sicurezza informatica e la trasparenza riguardo all’uso dei dati personali.

Quali sono le implicazioni etiche nell’utilizzo dell’Intelligenza Artificiale nei settori critici come la medicina e la giustizia?

L’utilizzo dell’IA in settori critici solleva importanti questioni etiche. Ad esempio, nella medicina, è necessario garantire la sicurezza dei pazienti e la correttezza delle diagnosi e dei trattamenti proposti dagli algoritmi. Nella giustizia, è importante assicurare la trasparenza e l’imparzialità nei processi decisionali automatizzati, evitando discriminazioni o errori giudiziari. È essenziale che l’implementazione dell’IA in questi settori sia guidata da principi etici come l’autonomia, la giustizia e il beneficio sociale.

Quali sono le prospettive future per lo sviluppo dell’Intelligenza Artificiale e come potrebbe influenzare la società nel lungo termine?

Le prospettive future per lo sviluppo dell’IA sono estremamente promettenti. Si prevede che l’IA continuerà a rivoluzionare molteplici settori, migliorando l’efficienza, l’automazione e la personalizzazione dei servizi. Tuttavia, è fondamentale affrontare le sfide legate all’etica, alla privacy e alla sicurezza nell’implementazione dell’IA. Nel lungo termine, l’IA potrebbe avere un impatto significativo sulla società, trasformando i modi in cui lavoriamo, interagiamo e viviamo. È importante che questo sviluppo avvenga in modo responsabile, garantendo che l’IA sia utilizzata per promuovere il benessere e l’equità per tutti.

È importante sottolineare che l’obiettivo principale dell’IA non è sostituire l’uomo, ma piuttosto integrare e supportare il lavoro umano, migliorando l’efficienza e la produttività. L’automazione e l’IA possono ridurre il carico di lavoro ripetitivo e consentire alle persone di concentrarsi su attività di valore aggiunto che richiedono abilità umane uniche.

Il tutto entro i limiti e i ranghi della protezione dei diritti patrimoniali e non dei soggetti che ne vengono impattati. La collaborazione tra l’uomo e l’intelligenza artificiale è la chiave per massimizzare i benefici di entrambi, attraverso una regolamentazione a tutto raggio come già sta avvenendo.

Un’alleanza che sfrutti i reciproci punti di forza può aspirare agli alti livelli di produttività che il nuovo paradigma tecnologico è in grado di sbloccare.

«Dobbiamo garantire che l’intelligenza artificiale rimanga sempre sotto il controllo umano. Questa deve essere la priorità sia per le aziende tecnologiche sia per i governi»

Brad Smith, Presidente di Microsoft

Bruxelles, 29 Giugno 2023

Articolo di Elisabetta Meggiorin, Angel Investor Accelera Hub